Nel panorama dell’intelligenza artificiale, Meta sta giocando una partita tutta sua. Mentre OpenAI, Google e Anthropic spingono sempre più verso ecosistemi chiusi, Meta rilancia con un approccio audace: intelligenza artificiale ad alte prestazioni, ma open weight, ovvero accessibile e riutilizzabile da chiunque (o quasi). L’ultima incarnazione di questa visione è Llama 4, un modello linguistico all’avanguardia, affiancato da due novità che stanno già facendo parlare di sé: Llama Scout e Maverick.

Che cos’è Llama 4?

Llama 4 è l’ultima evoluzione della famiglia LLaMA (Large Language Model Meta AI), una linea di modelli linguistici sviluppati da Meta a partire dal 2023. Fin dall’inizio, l’obiettivo di Meta è stato chiaro: democratizzare l’accesso all’intelligenza artificiale, rendendola più aperta, flessibile e trasparente rispetto ai competitor che proteggono i loro modelli dietro API proprietarie.

Il primo modello LLaMA è stato rilasciato nel febbraio 2023 come un progetto di ricerca: potente, ma pensato principalmente per la comunità scientifica. Llama 2, lanciato nel luglio dello stesso anno, ha segnato il vero punto di svolta: Meta ha deciso di rilasciare pesi open-weight anche per uso commerciale (con alcune restrizioni), rendendo Llama 2 una delle alternative più valide a GPT-3.5 in ambito enterprise.

Ora, con Llama 4, Meta fa un salto in avanti significativo in termini di capacità, efficienza e ambizione.

Cosa rende Llama 4 speciale?

Llama 4 rappresenta una netta evoluzione rispetto ai suoi predecessori su più fronti:

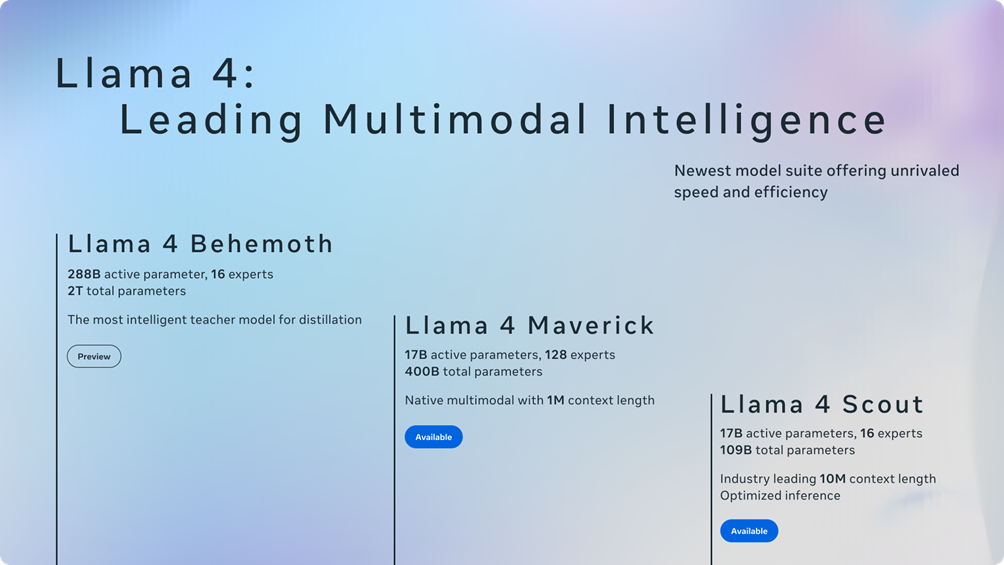

- Potenza e scalabilità: Llama 4 arriva in diverse dimensioni, tra cui la versione da 70 miliardi di parametri (70B), con una nuova architettura MoE (Mixture of Experts), capace di attivare solo una parte del modello alla volta. Risultato? Maggiore efficienza senza sacrificare le prestazioni.

- Maggiore accuratezza: secondo benchmark interni e test indipendenti, Llama 4 raggiunge o supera i risultati di GPT-4 su diversi task di ragionamento, comprensione e coding.

- Approccio “open”: non si tratta di open source puro (il codice completo non è disponibile), ma Meta continua a distribuire i pesi del modello, dando modo a sviluppatori, ricercatori e aziende di integrarlo nei propri sistemi.

- Versatilità: Llama 4 è pensato per lavorare su molteplici task, generazione di testo, traduzioni, coding, assistenza conversazionale, ed è ottimizzato per applicazioni su larga scala, anche in ambito enterprise.

Llama 4 nasce in un contesto in cui i grandi LLM sono sempre più centrali in prodotti e servizi. Se GPT-4 domina la scena e Claude 3 punta tutto sulla comprensione profonda e la sicurezza, Meta gioca un’altra carta: la libertà di sperimentare, adattare e costruire sull’AI, senza dover passare da una piattaforma chiusa.

Come funziona Llama 4

Capire come funziona Llama 4 significa entrare nel cuore della sua architettura. Non parliamo solo di “tanti parametri” o “reti neurali complesse”: qui c’è molto di più. La vera innovazione è nella struttura dinamica e modulare, pensata per offrire prestazioni top riducendo al minimo i costi computazionali.

Architettura MoE: potenza selettiva

Il cuore di Llama 4 è una Mixture of Experts (MoE), un’architettura che suddivide il modello in diversi “esperti” (pezzi indipendenti della rete neurale), di cui solo due vengono attivati per ogni input.

Cosa significa in pratica?

- Le risorse computazionali vengono concentrate su porzioni del modello realmente utili per ogni tipo di richiesta.

- Questo si traduce in un miglior rapporto qualità/prestazioni, soprattutto su hardware limitato o in cloud ottimizzati.

Performance e benchmark

Llama 4 ha mostrato ottimi risultati nei principali benchmark pubblici:

- MMLU (comprensione linguistica multi-task): competizione diretta con GPT-4.

- GSM8K (problem solving matematico): prestazioni in linea o superiori a Claude 3 Sonnet.

- HumanEval (scrittura e valutazione di codice): risultati convincenti, specialmente nella variante più grande.

Ma i numeri non raccontano tutto. Llama 4 è stato testato anche sul campo, in contesti come:

- Generazione creativa e copywriting

- Supporto tecnico via chatbot

- Analisi e sintesi di documenti lunghi

- Assistenza nella scrittura di codice

Capacità avanzate (multimodalità?)

Attualmente Llama 4 è ottimizzato per compiti testuali, ma Meta ha accennato a sviluppi futuri verso modelli multimodali, in grado di elaborare testo, immagini e suoni. Alcuni partner stanno già lavorando a versioni personalizzate con moduli visivi integrati.

Llama Scout e Maverick: i due nuovi modelli AI di Meta

Con il lancio di Llama 4, Meta non si è limitata a rilasciare un modello linguistico più potente. Ha introdotto due nuove entità AI distinte: Llama Scout e Llama Maverick. Due approcci diversi all’interazione con l’AI, che riflettono un cambio di paradigma: dal chatbot generico all’assistente proattivo e personalizzabile.

Vediamoli da vicino.

Llama Scout

Scout è pensato per essere un “co-pilota informativo”, una sorta di ricercatore AI che legge, esplora e sintetizza informazioni aggiornate dal mondo reale. Non si limita a generare testo sulla base del pre-training: sfrutta attivamente tecniche di RAG (Retrieval-Augmented Generation) e può accedere a fonti esterne in tempo reale.

Punti chiave di Llama Scout:

- È progettato per essere factually accurate, cioè preciso nei contenuti e aggiornato.

- Si comporta come un motore di ricerca AI-powered: consulta fonti, valuta attendibilità, e costruisce risposte argomentate.

- È ideale per compiti come:

-Analisi di mercato con dati recenti

-Sintesi di articoli di attualità

-Supporto decisionale

È aggiornato costantemente tramite accesso al web o database interni, a seconda dell’implementazione.

Llama Maverick

Maverick è invece un AI agent, ovvero un modello progettato per agire in modo più autonomo, svolgere compiti multi-step, prendere decisioni e interagire con strumenti esterni (API, software, calendari, documenti, ecc.).

È un’evoluzione dell’idea di “assistente virtuale”: non risponde soltanto, ma agisce, pianifica e completa task.

Cosa lo distingue:

- È autonomo, ma con margini di supervisione.

- Può orchestrare task complessi: es. leggere una mail, controllare il calendario, proporre tre opzioni per una riunione e inviarle.

- Si integra con strumenti: CRM, piattaforme interne, file system aziendali.

- È orientato a produttività e automazione.

Vantaggi e criticità di Llama 4

Llama 4 rappresenta un salto di qualità, ma non è privo di limiti e controversie. Come ogni modello AI di nuova generazione, apre opportunità entusiasmanti e solleva domande non banali.

Vantaggi di Llama 4

- Architettura moderna ed efficiente

Grazie al sistema MoE, Llama 4 riesce a garantire alte performance senza bisogno di risorse massicce. Questo lo rende più sostenibile per molte aziende rispetto ai modelli monolitici come GPT-4. - Open weight = più libertà

A differenza dei modelli completamente chiusi, Llama 4 può essere scaricato, eseguito in locale o in cloud, e personalizzato, pur con limitazioni legali. Questo è un game changer per aziende che cercano il controllo totale. - Ottimo equilibrio tra prestazioni e costi

Chi ha testato Llama 4 su progetti reali riporta prestazioni simili a GPT-4 a costi inferiori, soprattutto in ambienti self-hosted. - Scout e Maverick sono disruptive

Con questi due modelli Meta introduce un nuovo modo di pensare l’AI: non solo chatbot, ma agenti attivi, aggiornabili e integrabili nei workflow reali.

Criticità e limiti da considerare

- Hallucinations ancora presenti

Nonostante i progressi, Llama 4 può generare contenuti errati o fuorvianti. L’uso in ambiti sensibili (legale, medico, ecc.) richiede verifica umana costante. - Licenza non del tutto aperta

Llama 4 è “open-weight”, ma non completamente open source. Le restrizioni sull’uso commerciale (in particolare per le grandi aziende) possono limitarne la diffusione in certi ambienti. - Ecosistema ancora in crescita

Rispetto a ChatGPT o Claude, l’ambiente Llama (tooling, community, estensioni) è ancora meno maturo. Le aziende devono investire un po’ di più per ottenere un’esperienza fluida.

Conclusione

Con Llama 4, Scout e Maverick, Meta conferma la sua visione di un’intelligenza artificiale potente ma accessibile, capace di adattarsi a contesti reali, senza chiudersi in ecosistemi proprietari. Il rilascio open-weight, l’architettura efficiente e l’introduzione di modelli specializzati segnano un passo avanti concreto verso un’AI più modulare, personalizzabile e integrabile.